wget.exe -r -c --tries=3 --wait=1 --limit-rate=2m -l 1000 --html-extension --convert-links --no-parent --accept=index.html http://jediru.net/topic/1765/ -o log

Здесь скачивается тема номер 1765 с форума Костромских джедаев.

С количеством попыток = 3, опция зеркалирования включена, промежуток между скачкой файлов 1 секунда, с лимитом скорости 2 мегабита в секунду, рекурсивно 1000 раз (т.е. скачать повторно 1000 раз все встреченные ссылки), присваивать файлам расширение html, конвертировать ссылки на относительные (для локального просмотра), не переходить в каталог выше (не скачивать форум целиком!), скачивать только файл(ы) с именем index.html (оглавление каталога), вывод лога в файл log.

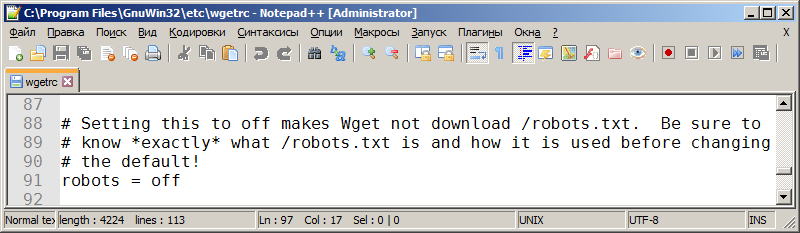

Для быстрой скачки можно заблокировать скачивание файла robots.txt в файле wgetrc:

# Setting this to off makes Wget not download /robots.txt. Be sure to

# know *exactly* what /robots.txt is and how it is used before changing

# the default!

robots = off